唐剛老師: Cloudera原廠授權講師。北航碩士,10年IT研發與培訓經驗,對Java、Hadoop、Scala、Spark、數據挖掘、機器學習等大數據技術具有深厚的技術功底,曾參與開發電商日志分析、廣告實時推薦、金融異常交易預警、基于GPS的實時路況分析、超速頻發路段監控等項目。

5、6年前,大數據的概念還不為人所知,Hadoop更是沒幾個人知道,唐剛老師由于工作上的因緣,幸運的成為最早接觸并使用Hadoop進行大數據開發的那批人。在后來的日子,他沒有像其他人那樣去大公司做高管或者創業,而是慢慢走上了大數據開發的培訓之路。

唐剛老師認為技術講師是一份對人要求更高的工作,不僅要走在技術的前沿,還要善于講解和表達。五年多來,他一直在大力推行Hadoop和Spark,但仍有不少人對這兩種開發工具的運用表示困惑或帶有誤解。在采訪中,唐剛老師結合自己的經歷,探討了Hadoop和Spark的優劣和應用,并給出了學習建議和學習路徑,數據妞希望能對有志轉型大數據或步入大數據行業的人有所幫助。

數據妞:能否談談您與Hadoop的接觸經歷?

唐剛:我大學讀的是計算機,但那時候我對編程其實沒有什么興趣。在學校里我們學的是C語言、匯編語言等等,采用的都是DOS界面,非常枯燥。這種感覺直到接觸VB才大大改變,因為VB是有可視化效果的,我才覺得原來編程也挺好玩的。后來我又接觸了Java,畢業之后就一直在做Java開發。

2010年到2011年那時,我工作的公司要做一個Java Web的項目,數據量非常大,用Java去查詢數據的時候速度非常慢,我們就想辦法如何去解決這個問題。那段時間我在一個國外的技術網站上看到了Hadoop,我才知道原來還有這樣一個東西,它可以有效提升數據處理的速度,于是我在一次公司例會上提議學習Hadoop。

那時候國內幾乎沒人用Hadoop,就連知道的人也很少,我們學習途徑主要就通過Hadoop的官方網站。另外幸運的是,我有一個朋友當時在讀研,他的研究生畢業論文就是要用Hadoop 去做的,于是我有什么問題就向這個朋友討教。

我們大概花了半年時間才完成了轉型,可以說非常吃力。一是當時學習途徑很狹窄,沒有中文資料,也沒有什么書籍,資料匱乏,一個組件可能就要研究很長時間。二是時間少,我要在完成本職工作之后再抽時間一點一點學。不過雖然辛苦,但帶給我最大的好處就是我很早就與大數據開發結緣。

數據妞:您目前的工作是什么,為何有這樣的職業選擇?

唐剛:目前我在光環國際擔任大數據教學總監,主要工作是針對大數據開發方面的培訓。

以前和我一起學習Hadoop的人現在基本都混得很不錯,有不少人都在做CTO或是總監級別的了。而我是因為在2011年之前曾在一些培訓機構兼職講課,從那時候開始就漸漸喜歡上了講課,于是我跳槽之后就去了一家IT培訓公司,一邊大力推廣Hadoop,一邊做大數據項目的研發。

我認為做技術講師是一件高難度的工作。做技術講師首先要懂技術,要保持自己技術的先進性,其次你要能準確、合適地進行表達,因為技術是很抽象、很枯燥、很難理解的東西,你需要用近似于“大白話”的方式去說明專業的技術問題,這個對人的提高是很大的。我現在也一直在研究前沿技術,最近我一直在研究Spark和機器學習。

數據妞:您認為是什么造成了Hadoop的流行?

唐剛:Hadoop之所以能流行主要是因為大數據對存儲、處理的要求比傳統數據要高得多。

由于互聯網(特別是移動互聯網)的發展,每天都會產生大量的數據,產生數據的渠道比之前也多了很多。這些數據通過日積月累就會變成海量的大數據。

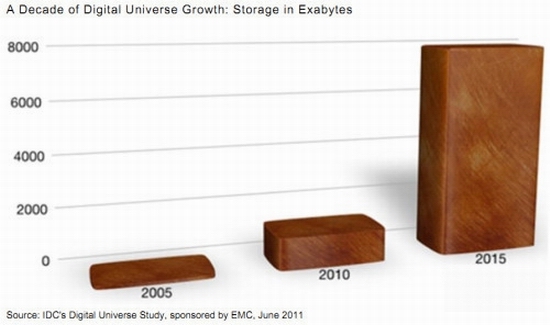

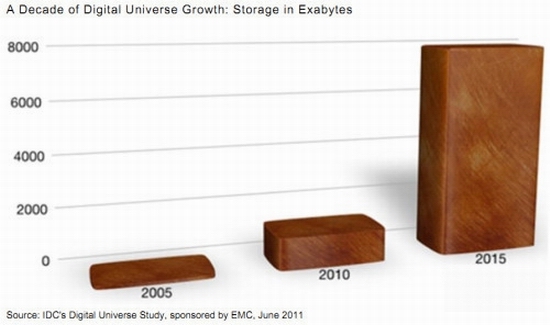

2011年全球被創建和復制的數據總量為1.8ZB(10的21次方),其中75%來自于個人,遠遠超過人類有史以來所有印刷材料的數據總量(200PB)。過去幾年全世界產生的數據量甚至超過了歷史上2萬年來產生的數據量的總和。(資料來源:IDC研究報告《從混沌中提取價值》)

現在人們常說的數據挖掘、數據分析并不是新的東西,在之前已經存在很久了。但大數據時代和以前不一樣,大數據如果還用以前的手段進行存儲、分析是很困難的。然而Hadoop在處理海量大數據方面就非常有優勢,所以可以說Hadoop是應大數據時代之勢而流行起來。

Hadoop的優勢主要體現在兩方面:第一,它可以通過HDFS把數據進行分布式的存儲,這就解決了大數據的存儲問題;第二,它有MapReduce,通過編寫Map函數和Reduce函數解決了大數據的計算處理問題。目前Hadoop在大數據開發領域仍然占主流。

數據妞:Spark是何時發展起來的?Spark會取代Hadoop嗎?

唐剛:Spark大概是在2013年傳入中國的,在2014年左右就出現了一些觀點,認為Spark會取代Hadoop,或者“Spark一出,Hadoop必死”。但是我始終認為,大數據開發這個行業肯定是百家爭鳴、多平臺共存的行業。直到目前,我們也發現Hadoop并沒有因為Spark的出現而消亡,Hadoop和 Spark都有它的優勢和劣勢。

從數據存儲的角度來看:目前Spark生態體系中缺少一個類似于Hadoop的HDFS的子項目。HDFS(文件分布式系統)屬于Hadoop生態體系的,是一個非常優秀的分布式文件系統,解決了大數據的存儲問題,還有YARN平臺也是一個非常優秀的資源管理系統。Spark缺少像HDFS這樣一個框架,所以Spark要依賴于HDFS來進行存儲。Spark在進行開發時也會用到YARN平臺或者Mesos。

從數據處理速度的角度看:相比Spark,Hadoop最大的問題是處理速度慢。MapReduce產生的中間結果是放到磁盤當中的,如果我要用到Map產生的中間結果,我需要先從磁盤中讀取到內存中再使用,如果又產生一個中間結果,這個中間結果又要先放到磁盤當中,再從磁盤讀取到內存當中才能使用,所以說MapReduce存在無法避免的磁盤輸入輸出的過程,這在速度上是一個很大的缺陷。

但是Spark就不一樣了。Spark處理數據所產生的中間結果放在內存中,要用的時候直接從內存讀取就可以了,少了磁盤輸入輸出的過程,速度比Hadoop要快。

從編碼的角度看:在MapReduce中,需要編寫Map函數和Reduce函數,不管做什么處理,必須編寫這2個函數。Hadoop的源碼是Java,用Java編寫MapReduce比較麻煩、繁瑣,有時候代碼量也挺大的。

Spark的源碼是Scala,Scala寫起來比較簡潔,所以用Scala來開發Spark要簡單得多。

Hadoop在目前大數據開發的領域仍然占主流,但是Spark的發展速度是非常快的,它是一個非常有發展潛力的框架。Hadoop更加偏向于離線批處理,Spark既可以進行離線批處理計算,也可以進行交互式計算,還可以對數據流進行準實時計算。

數據妞:國內外對Hadoop和Spark的應用情況如何?

唐剛:Hadoop、Spark的實際應用有很多。包括政府的輿情管理,例如我國的網絡輿情監測系統;電信行業,例如移動、聯通這樣的電信運營商做精準營銷(客戶畫像、關系鏈研究、實時營銷和個性化推薦等);電商行業,如淘寶、天貓、京東做的個性化推薦和客戶消費習慣預測;此外在教育、醫療、交通行業、農業、金融行業也有很多應用,如預防金融犯罪、預測農產品價格等等。

圖為百度交通大數據成果展中的出租車運力圖(圖片來源:國家測繪地理信息局)

圖為百度交通大數據成果展中的出租車運力圖(圖片來源:國家測繪地理信息局)

國外也有不少公司在做大數據,比如Cloudera、MapR、雅虎、Facebook(推出了Hive)、推特、谷歌、IBM等等,應用也非常廣泛。國內也有不少,比如BAT、京東、美團、亞信、去哪兒等。

數據妞:對于轉型大數據的開發人員有哪些建議?

唐剛:對于想要轉型大數據開發的IT人,有以下幾點需要注意:

第一,他最好有一定的開發經歷,不管做哪方面的開發,也不管是Java、.NET、PHP,至少要掌握一門編程語言。因為大數據開發肯定離不開寫代碼。

第二,要對數據敏感。做Java開發、Android開發更多的是強調邏輯思維,但是大數據開發不僅強調邏輯思維,還要對數字敏感。學數學或相關專業的人來做大數據是有一定先天優勢的,因為他有本身經過多年的學習,對數字、數據很敏感,很適合做數據分析挖掘的工作。如果他想做大數據開發,還需要去學習一門編程語言,比如Java等等。

數據妞:假如我不會編程語言,數學功底也不好,又想從事大數據開發該怎么辦?

唐剛:首先,從掌握一門編程語言開始。關于編程語言的推薦,我認為還是Java比較好。因為Hadoop目前仍然是大數據開發的主流工具,它的源碼是用Java寫的。而且在掌握Java之后再看Scala(Spark的源碼)就比較簡單了,Scala是一種函數式編程,掌握Java之后可以更好地理解函數式編程。

其次,大數據開發不需要用到很高端的數學知識,只有機器學習部分會有一些算法,這些是可以在工作當中通過項目實踐來彌補的。

在職業規劃上,我個人建議如果有機會就要去大公司磨練。因為大公司的技術比較前沿,接觸新技術的途徑也比較多,可以學到很多東西,對今后的職業生涯也有更好的保證。

數據妞:想要自學的話,有什么推薦的書籍和學習方式嗎?

唐剛:可以學習的書籍太多了,比如《Hadoop權威指南》。

最好的學習途徑其實就是官方網站,最好的學習資料就是官方文檔,要經常去Hadoop和Spark的官網看第一手資料。雖然這兩個官網都是英文的,一開始可能會讓人覺得吃力,但時間長了就順了,一方面可以學到Hadoop和Spark的技術,另一方面還可以提高英文閱讀水平。

Hadoop官網

Hadoop官網

另外還有一些學習方法也是很好的:

有問題多百度,因為你遇到的問題別人在學習當中也可能會遇到,所以有什么問題找百度;

多去一些諸如CSDN等優秀的技術網站,這些網站有很多關于大數據開發的技術資料;

多看一些技術大拿寫的博客,學習他們的經驗和方法,包括看他們寫的代碼,學習他們解決問題的思路和方法;

大數據開發始終離不開寫代碼,作為一名大數據開發者要多寫代碼,經常Coding,加深對技術的理解和熟練度;

如果公司里有大數據項目是非常好的,可以通過項目實踐的方式來學習。

數據妞:深入進修Hadoop和Spark都要注意什么?

唐剛:到了大數據開發的高端領域是離不開機器學習的,開發者不僅要寫代碼,還要懂算法,懂算法的實現過程。Hadoop生態體系當中的Mahout 、Spark生態體系當中的MLlib都是進行數據挖掘的工具,可以把機器學習的一些算法應用到Hadoop和Spark的大數據開發當中。

現在咱們常常提到機器學習,實際上這些學科在以前早就有了,但是當時的數據量沒有達到現在的級別,機器學習的作用還無法得到很好的發揮。現在進入到了大數據時代,機器學習有了更好的“用武之地”。可以說,大數據促進了機器學習。

數據妞:關于Hadoop和Spark的學習路徑可否介紹一下?

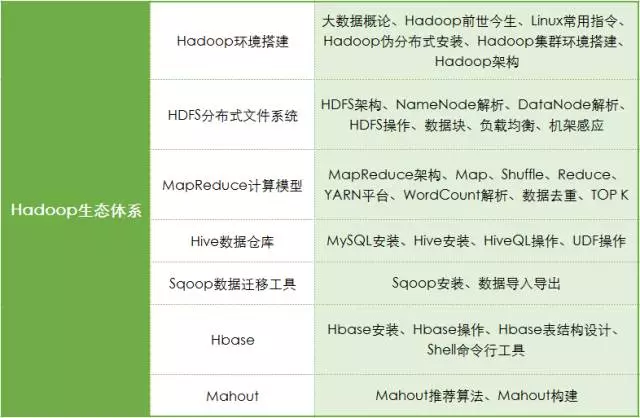

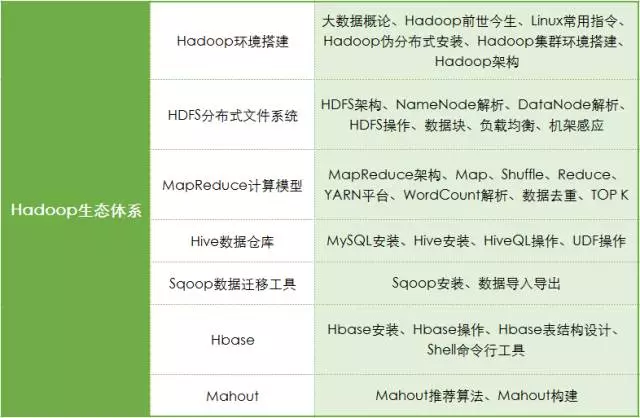

唐剛:Hadoop的一個大概的學習路徑是這樣的:除了搭建集群,首先要學習HDFS和YARN平臺,然后是MapReduce、Hive,之后可以學習HBase,再往高級可以學習Mahout。

Spark除了搭建集群以外,第一個要學習RDD編程,RDD是彈性分布式數據集,然后是Spark SQL,再往下是Spark Streaming,之后是MLlib(相當于Hadoop中的Mahout),如果想再繼續深入可以學習圖計算GraphX。

大數據分析和數據挖掘則是另外一個方向,它用到的工具和語言有SAS、SPSS、R語言、Python。

大數據分析和大數據開發是兩個方向,兩套體系,現在最稀缺的還是大數據開發人員。數據分析相對來說門檻較低,而大數據開發人員要懂框架、會寫代碼、有數據思維、有邏輯思維,還要懂機器學習的算法,門檻就比較高,這從薪資待遇上來說也有所體現。

唐剛老師: Cloudera原廠授權講師。北航碩士,10年IT研發與培訓經驗,對Java、Hadoop、Scala、Spark、數據挖掘、機器學習等大數據技術具有深厚的技術功底,曾參與開發電商日志分析、廣告實時推薦、金融異常交易預警、基于GPS的實時路況分析、超速頻發路段監控等項目。

5、6年前,大數據的概念還不為人所知,Hadoop更是沒幾個人知道,唐剛老師由于工作上的因緣,幸運的成為最早接觸并使用Hadoop進行大數據開發的那批人。在后來的日子,他沒有像其他人那樣去大公司做高管或者創業,而是慢慢走上了大數據開發的培訓之路。

唐剛老師認為技術講師是一份對人要求更高的工作,不僅要走在技術的前沿,還要善于講解和表達。五年多來,他一直在大力推行Hadoop和Spark,但仍有不少人對這兩種開發工具的運用表示困惑或帶有誤解。在采訪中,唐剛老師結合自己的經歷,探討了Hadoop和Spark的優劣和應用,并給出了學習建議和學習路徑,數據妞希望能對有志轉型大數據或步入大數據行業的人有所幫助。

數據妞:能否談談您與Hadoop的接觸經歷?

唐剛:我大學讀的是計算機,但那時候我對編程其實沒有什么興趣。在學校里我們學的是C語言、匯編語言等等,采用的都是DOS界面,非常枯燥。這種感覺直到接觸VB才大大改變,因為VB是有可視化效果的,我才覺得原來編程也挺好玩的。后來我又接觸了Java,畢業之后就一直在做Java開發。

2010年到2011年那時,我工作的公司要做一個Java Web的項目,數據量非常大,用Java去查詢數據的時候速度非常慢,我們就想辦法如何去解決這個問題。那段時間我在一個國外的技術網站上看到了Hadoop,我才知道原來還有這樣一個東西,它可以有效提升數據處理的速度,于是我在一次公司例會上提議學習Hadoop。

那時候國內幾乎沒人用Hadoop,就連知道的人也很少,我們學習途徑主要就通過Hadoop的官方網站。另外幸運的是,我有一個朋友當時在讀研,他的研究生畢業論文就是要用Hadoop 去做的,于是我有什么問題就向這個朋友討教。

我們大概花了半年時間才完成了轉型,可以說非常吃力。一是當時學習途徑很狹窄,沒有中文資料,也沒有什么書籍,資料匱乏,一個組件可能就要研究很長時間。二是時間少,我要在完成本職工作之后再抽時間一點一點學。不過雖然辛苦,但帶給我最大的好處就是我很早就與大數據開發結緣。

數據妞:您目前的工作是什么,為何有這樣的職業選擇?

唐剛:目前我在光環國際擔任大數據教學總監,主要工作是針對大數據開發方面的培訓。

以前和我一起學習Hadoop的人現在基本都混得很不錯,有不少人都在做CTO或是總監級別的了。而我是因為在2011年之前曾在一些培訓機構兼職講課,從那時候開始就漸漸喜歡上了講課,于是我跳槽之后就去了一家IT培訓公司,一邊大力推廣Hadoop,一邊做大數據項目的研發。

我認為做技術講師是一件高難度的工作。做技術講師首先要懂技術,要保持自己技術的先進性,其次你要能準確、合適地進行表達,因為技術是很抽象、很枯燥、很難理解的東西,你需要用近似于“大白話”的方式去說明專業的技術問題,這個對人的提高是很大的。我現在也一直在研究前沿技術,最近我一直在研究Spark和機器學習。

數據妞:您認為是什么造成了Hadoop的流行?

唐剛:Hadoop之所以能流行主要是因為大數據對存儲、處理的要求比傳統數據要高得多。

由于互聯網(特別是移動互聯網)的發展,每天都會產生大量的數據,產生數據的渠道比之前也多了很多。這些數據通過日積月累就會變成海量的大數據。

2011年全球被創建和復制的數據總量為1.8ZB(10的21次方),其中75%來自于個人,遠遠超過人類有史以來所有印刷材料的數據總量(200PB)。過去幾年全世界產生的數據量甚至超過了歷史上2萬年來產生的數據量的總和。(資料來源:IDC研究報告《從混沌中提取價值》)

現在人們常說的數據挖掘、數據分析并不是新的東西,在之前已經存在很久了。但大數據時代和以前不一樣,大數據如果還用以前的手段進行存儲、分析是很困難的。然而Hadoop在處理海量大數據方面就非常有優勢,所以可以說Hadoop是應大數據時代之勢而流行起來。

Hadoop的優勢主要體現在兩方面:第一,它可以通過HDFS把數據進行分布式的存儲,這就解決了大數據的存儲問題;第二,它有MapReduce,通過編寫Map函數和Reduce函數解決了大數據的計算處理問題。目前Hadoop在大數據開發領域仍然占主流。

數據妞:Spark是何時發展起來的?Spark會取代Hadoop嗎?

唐剛:Spark大概是在2013年傳入中國的,在2014年左右就出現了一些觀點,認為Spark會取代Hadoop,或者“Spark一出,Hadoop必死”。但是我始終認為,大數據開發這個行業肯定是百家爭鳴、多平臺共存的行業。直到目前,我們也發現Hadoop并沒有因為Spark的出現而消亡,Hadoop和 Spark都有它的優勢和劣勢。

從數據存儲的角度來看:目前Spark生態體系中缺少一個類似于Hadoop的HDFS的子項目。HDFS(文件分布式系統)屬于Hadoop生態體系的,是一個非常優秀的分布式文件系統,解決了大數據的存儲問題,還有YARN平臺也是一個非常優秀的資源管理系統。Spark缺少像HDFS這樣一個框架,所以Spark要依賴于HDFS來進行存儲。Spark在進行開發時也會用到YARN平臺或者Mesos。

從數據處理速度的角度看:相比Spark,Hadoop最大的問題是處理速度慢。MapReduce產生的中間結果是放到磁盤當中的,如果我要用到Map產生的中間結果,我需要先從磁盤中讀取到內存中再使用,如果又產生一個中間結果,這個中間結果又要先放到磁盤當中,再從磁盤讀取到內存當中才能使用,所以說MapReduce存在無法避免的磁盤輸入輸出的過程,這在速度上是一個很大的缺陷。

但是Spark就不一樣了。Spark處理數據所產生的中間結果放在內存中,要用的時候直接從內存讀取就可以了,少了磁盤輸入輸出的過程,速度比Hadoop要快。

從編碼的角度看:在MapReduce中,需要編寫Map函數和Reduce函數,不管做什么處理,必須編寫這2個函數。Hadoop的源碼是Java,用Java編寫MapReduce比較麻煩、繁瑣,有時候代碼量也挺大的。

Spark的源碼是Scala,Scala寫起來比較簡潔,所以用Scala來開發Spark要簡單得多。

Hadoop在目前大數據開發的領域仍然占主流,但是Spark的發展速度是非常快的,它是一個非常有發展潛力的框架。Hadoop更加偏向于離線批處理,Spark既可以進行離線批處理計算,也可以進行交互式計算,還可以對數據流進行準實時計算。

數據妞:國內外對Hadoop和Spark的應用情況如何?

唐剛:Hadoop、Spark的實際應用有很多。包括政府的輿情管理,例如我國的網絡輿情監測系統;電信行業,例如移動、聯通這樣的電信運營商做精準營銷(客戶畫像、關系鏈研究、實時營銷和個性化推薦等);電商行業,如淘寶、天貓、京東做的個性化推薦和客戶消費習慣預測;此外在教育、醫療、交通行業、農業、金融行業也有很多應用,如預防金融犯罪、預測農產品價格等等。

圖為百度交通大數據成果展中的出租車運力圖(圖片來源:國家測繪地理信息局)

圖為百度交通大數據成果展中的出租車運力圖(圖片來源:國家測繪地理信息局)

國外也有不少公司在做大數據,比如Cloudera、MapR、雅虎、Facebook(推出了Hive)、推特、谷歌、IBM等等,應用也非常廣泛。國內也有不少,比如BAT、京東、美團、亞信、去哪兒等。

數據妞:對于轉型大數據的開發人員有哪些建議?

唐剛:對于想要轉型大數據開發的IT人,有以下幾點需要注意:

第一,他最好有一定的開發經歷,不管做哪方面的開發,也不管是Java、.NET、PHP,至少要掌握一門編程語言。因為大數據開發肯定離不開寫代碼。

第二,要對數據敏感。做Java開發、Android開發更多的是強調邏輯思維,但是大數據開發不僅強調邏輯思維,還要對數字敏感。學數學或相關專業的人來做大數據是有一定先天優勢的,因為他有本身經過多年的學習,對數字、數據很敏感,很適合做數據分析挖掘的工作。如果他想做大數據開發,還需要去學習一門編程語言,比如Java等等。

數據妞:假如我不會編程語言,數學功底也不好,又想從事大數據開發該怎么辦?

唐剛:首先,從掌握一門編程語言開始。關于編程語言的推薦,我認為還是Java比較好。因為Hadoop目前仍然是大數據開發的主流工具,它的源碼是用Java寫的。而且在掌握Java之后再看Scala(Spark的源碼)就比較簡單了,Scala是一種函數式編程,掌握Java之后可以更好地理解函數式編程。

其次,大數據開發不需要用到很高端的數學知識,只有機器學習部分會有一些算法,這些是可以在工作當中通過項目實踐來彌補的。

在職業規劃上,我個人建議如果有機會就要去大公司磨練。因為大公司的技術比較前沿,接觸新技術的途徑也比較多,可以學到很多東西,對今后的職業生涯也有更好的保證。

數據妞:想要自學的話,有什么推薦的書籍和學習方式嗎?

唐剛:可以學習的書籍太多了,比如《Hadoop權威指南》。

最好的學習途徑其實就是官方網站,最好的學習資料就是官方文檔,要經常去Hadoop和Spark的官網看第一手資料。雖然這兩個官網都是英文的,一開始可能會讓人覺得吃力,但時間長了就順了,一方面可以學到Hadoop和Spark的技術,另一方面還可以提高英文閱讀水平。

Hadoop官網

Hadoop官網

另外還有一些學習方法也是很好的:

有問題多百度,因為你遇到的問題別人在學習當中也可能會遇到,所以有什么問題找百度;

多去一些諸如CSDN等優秀的技術網站,這些網站有很多關于大數據開發的技術資料;

多看一些技術大拿寫的博客,學習他們的經驗和方法,包括看他們寫的代碼,學習他們解決問題的思路和方法;

大數據開發始終離不開寫代碼,作為一名大數據開發者要多寫代碼,經常Coding,加深對技術的理解和熟練度;

如果公司里有大數據項目是非常好的,可以通過項目實踐的方式來學習。

數據妞:深入進修Hadoop和Spark都要注意什么?

唐剛:到了大數據開發的高端領域是離不開機器學習的,開發者不僅要寫代碼,還要懂算法,懂算法的實現過程。Hadoop生態體系當中的Mahout 、Spark生態體系當中的MLlib都是進行數據挖掘的工具,可以把機器學習的一些算法應用到Hadoop和Spark的大數據開發當中。

現在咱們常常提到機器學習,實際上這些學科在以前早就有了,但是當時的數據量沒有達到現在的級別,機器學習的作用還無法得到很好的發揮。現在進入到了大數據時代,機器學習有了更好的“用武之地”。可以說,大數據促進了機器學習。

數據妞:關于Hadoop和Spark的學習路徑可否介紹一下?

唐剛:Hadoop的一個大概的學習路徑是這樣的:除了搭建集群,首先要學習HDFS和YARN平臺,然后是MapReduce、Hive,之后可以學習HBase,再往高級可以學習Mahout。

Spark除了搭建集群以外,第一個要學習RDD編程,RDD是彈性分布式數據集,然后是Spark SQL,再往下是Spark Streaming,之后是MLlib(相當于Hadoop中的Mahout),如果想再繼續深入可以學習圖計算GraphX。

大數據分析和數據挖掘則是另外一個方向,它用到的工具和語言有SAS、SPSS、R語言、Python。

大數據分析和大數據開發是兩個方向,兩套體系,現在最稀缺的還是大數據開發人員。數據分析相對來說門檻較低,而大數據開發人員要懂框架、會寫代碼、有數據思維、有邏輯思維,還要懂機器學習的算法,門檻就比較高,這從薪資待遇上來說也有所體現。